地端AI革命: 如何運用Intel、MediaTek、Rockchip 打造多模態大模型的智慧新紀元

2025-07-07

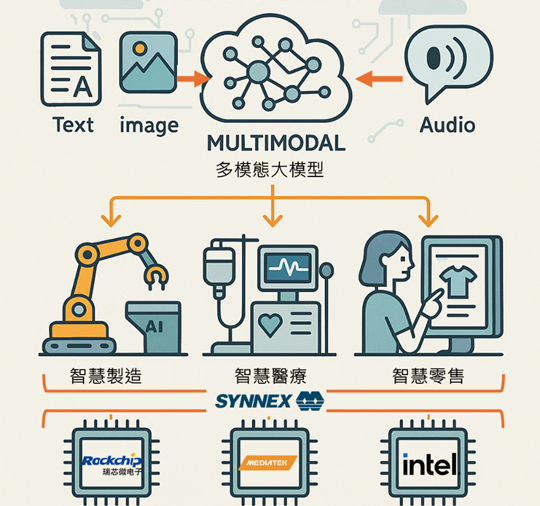

在當今數位轉型快速推進的時代,人工智慧技術正帶來顛覆性變革。 多模態大模型不僅可以同時處理文字、圖像與語音等多種數據格式,還能通過跨模態的數據融合來提供更全面及精準的應用體驗,比起單純的大型語言模型(LLM),能賦予機器更貼近人類的理解方式。 這種技術的突破,正為各大應用領域注入前所未有的活力與可能性。 與此同時,邊緣(地端)部署成為實現即時反饋與數據隱私保護的關鍵。 相比傳統的雲端解決方案,邊緣運算能夠顯著降低系統延遲、減少數據傳輸風險並節省雲端資源成本,完美契合當下對高速、穩定與安全應用需求的追求。 這使得在地端設備上部署多模態大模型成為驅動智慧應用升級的重要戰略,非常適用各種高即時性需求與高隱私性需求的應用場域,例如工廠自動化設備中,或是醫療場所裡。 為了滿足市場對高效能與低功耗AI解決方案的期待,業界眾多晶片製造商如Intel(英特爾)、MediaTek(聯發科技)以及Rockchip(瑞芯微電子),正不斷推出針對邊緣應用而最佳化的硬體平台及軟體開發解決方案。 這些產品不僅在運算能力、功耗與多媒體處理等方面各具優勢,更為多模態大模型在現實應用中的快速部署提供了強有力的技術支撐,大幅加速客戶開發時間,讓產品能更快速落地。 本文將深入探討如何利用這些先進晶片平台,從技術原理到具體應用,全面解析多模態大模型在邊緣部署上的核心價值與優勢,並為開發者提供選擇合適解決方案的實戰指南。 讓我們共同展開邊緣智能新紀元的探索,迎接未來智慧應用的無限可能!

多模態大模型技術概述

多模態大模型是一種能夠整合文字、圖像與語音等多種類型數據的先進深度學習模型。 這類模型概念與優勢主要在於:

.融合不同數據類型:

透過專門設計的編碼器,模型能將各種模態(文字、音訊、圖案等)的原始數據轉換為統一的高維度向量,使得數據之間能以相同的資訊格式來融合與處理。 這種跨模態的資訊整合可以顯著提升模型預測的精度和豐富用戶體驗,因為它能夠捕捉到傳統單一數據來源模型所無法展現的細微特徵與關聯性。

.提昇使用者體驗:

多模態的加入不僅拓展了人機互動的可能性,也使得應用系統能根據多維度訊息進行更智慧的決策,從而提供更加精準和直觀的回饋。

然而,這樣的技術在實際運用中也面臨不少關鍵技術挑戰,其中包括:

.資料預處理:

不同數據類型往往具有各自獨特的特徵與雜訊資料,在進行統一處理前,需要投入大量數據清洗、標準化以及特徵提取工作,確保最終融合的訊息足夠準確。

.極高運算量:

多模態大模型由於同時處理大規模的多來源數據,其運算需求遠超傳統單一模態模型。 這對於硬體資源有較高要求,尤其是在邊緣設備上部署時,更需在運算效能與電力消耗之間取得平衡。

.即時推理需求:

在許多即時的場景(如智慧城市管理、工業自動化等)中,模型必須在極短的延遲內完成數據處理和決策,這就要求硬體平台能夠提供快速而穩定的推理支持。

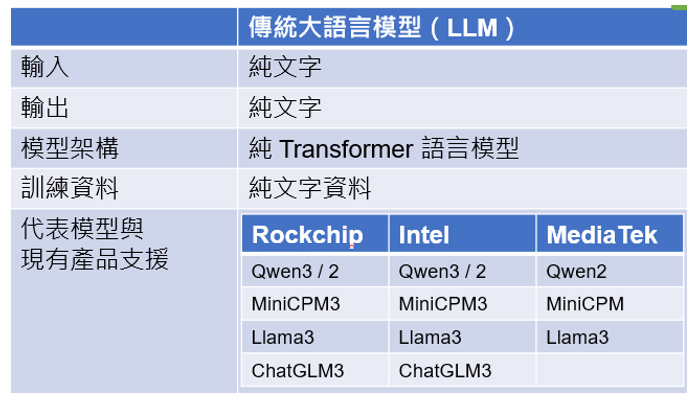

傳統大語言模型特性

多模態大模型特性

邊緣部署的優勢與應用場景

.核心優勢:

邊緣部署不僅能夠將數據存儲和運算搬到離數據來源更近的地方,從而實現低延遲和即時反應,還能在數據安全和隱私保護方面發揮巨大的作用。 對於多模態大模型來說,這種策略特別適用於對各類數據(如影像、語音、文字等)需要及時合作處理的場景。 較之傳統的純雲端部署,邊緣運算能夠在本地快速篩選和預處理數據,緩解因遠距離傳輸帶來的延遲和安全隱患,同時大幅降低了對雲端資源的依賴與相應成本。

.雲端與邊緣佈署混合使用的趨勢:

雲端擁有強大的計算能力,可承擔大規模的模型,但由於數據傳輸延遲和隱私顧慮,在互動和現場決策上仍不如邊緣部署靈活。 因此,很多應用開始採取混合部署模式,邊緣端用以完成數據預處理、即時推理和安全存儲,而雲端則承擔模型更新、精細化分析和大規模數據訓練的任務。 這種「邊雲協同」方案正日益成為業界的發展趨勢,為多模態AI應用提供了最佳平衡,使得在保留雲端強大運算能力的同時,也能享受到邊緣部署所帶來的低延遲與強隱私保護優勢。

.多模態特色與典型地端邊緣佈署應用案例:

1.智慧零售與智能監控:

想像一個智慧零售環境,門店中裝有視訊監控、聲音識別和環境感測器,並有智慧POS機與客戶互動,它們一起生成多維度數據。 邊緣設備能在店家即時進行初步數據融合與分析,識別客群行為或異常事件,而更複雜的模式識別和決策則可由雲端模型後續處理,從而實現「即時反饋+持續最佳化」雙重保障的高效運營。

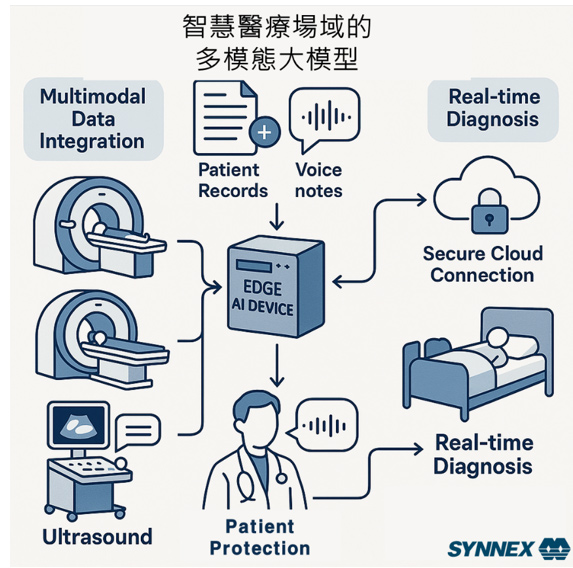

2.醫療影像與遠程診斷:

醫療影像數據通常來自不同模態,如CT、MRI與超聲波影像,結合病歷文字描述和語音解讀,構成了典型的多模態資料。 在醫院內部的設備上,對敏感數據進行即時處理與初步診斷,可以保障病患隱私並縮短診斷時,達到最佳的診斷效果。

.Intel平台上實現多模態模型

自2018年推出以來,OpenVINO™已成為Intel平台上統一的AI推論工具,支援包括CPU、內建顯示卡(iGPU)、獨立顯示卡(dGPU)以及NPU等多種硬體架構。 透過一致的API介面與開發工具,OpenVINO讓開發者能夠靈活調度各種算力資源,充分發揮AI模型的效能潛力。 OpenVINO不僅提供豐富的範例程式碼、技術文件與活躍的社群支援,也在多模態模型的推論方面展現強大能力。 例如,針對Qwen2-VL-7B-Instruct這款多模態大模型,在搭載Intel® Core™ Ultra 7 Processor 155H(Meteor Lake)的平台上,透過iGPU推論可達15 Tokens/sec; 若使用 Intel® Arc™ B580獨立顯示卡(dGPU),效能更可提升至57 Tokens/sec。 這樣的架構設計與工具整合,使得在Intel平台上部署多模態AI模型不僅高效、靈活,也更容易進行效能最佳化與跨平台擴展。

* 關於Intel及相關產品的最新資訊與合作,歡迎聯繫 CBGIntelFAE@synnex.com.tw

* 測試數據由 OpenVINO Model Hub文件,基於OpenVINO v2025.2測試結果提供。

.MediaTek Genio平台上實現多模態模型:

MediaTek(聯發科技)推出的Genio 2系列產品(如G720、G520等),內建擁有高算力的 NPU,整體計算能力可達到9.1 TOPS。 這全新一代的NPU專為支援多模態模型的推論而設計,能夠有效處理例如LLaVA等大型多模態模型,滿足即時推論與高精度處理的需求。

在軟體方面,MediaTek Genio平台提供了強大的AI開發生態系統,通過NeuroPilot及LLM SDK幫助開發者簡化從模型量化、轉換到效能驗證的全流程。 MediaTek Genio平台及其完整的軟體工具鏈,不僅簡化了多模態模型從研發到部署的流程,也為客戶提供了一條高效率、低功耗且易於定制與驗證的技術路徑,使得在智慧城市、智能監控、工業自動化等場景下能夠迅速落地高品質的AI解決方案。

* 關於MediaTek及相關產品的最新資訊與合作,歡迎聯繫 synnex_6N@synnex.com.tw

Rockchip(瑞芯微電子)的RK3588、RK3576、RK3562、RV1126B等產品,內建高算力的 NPU。 這些產品不僅針對影像處理、語音識別及自然語言處理等應用進行了硬體最佳化,也特別適合搭載與運行多模態大模型,為開發者提供了高性能、低功耗的解決方案。

軟體上透過RKNN以及RKLLM-SDK來進行開發實現,在GitHub上提供了完整的範例程式碼與各類經過優化的模型。 這些資源不僅展示了如何利用RKLLM-SDK在Rockchip系列產品上進行大語言模型或多模態模型部署,還提供了各種模型推論的實例,供開發者參考和驗證解決方案的效果。

以多模態模型Qwen2-VL-2B為例,在具有6TOPS NPU的RK3588/RK3576上推論速度可達到 13~16 Tokens/sec,這一成果彰顯了Rockchip平台對高運算量應用的卓越支援能力,創造了極具競爭力的市場優勢。

* 關於Intel及相關產品的最新資訊與合作,歡迎聯繫 synnex_6N@synnex.com.tw

* 測試數據基於Rockchip於rknn-toolkit2 v2.2.0在GitHub airockchip/rknn-llm ,發布之結果。

.聯強與您攜手打造地端AI的智慧新紀元

隨著多模態大模型技術的快速演進,以及地端運算平台的持續創新,AI應用正以前所未有的速度走入各行各業。 Intel、MediaTek、Rockchip等領先晶片平台,已為智慧製造、醫療影像、零售監控等場景提供了強大支撐,讓多模態AI真正落地、即時反應、安全可靠。

我們誠摯邀請您與我們聯繫,探索如何將這些先進技術應用於您的產品與解決方案中。 我們不僅提供完整的產品線與技術支援,更能協助您快速導入AI能力、縮短開發週期、提升市場競爭力。

歡迎聯繫我們的技術與業務團隊,取得最新產品資訊、開發資源與合作方案:

• Intel平台合作: CBGIntelFAE@synnex.com.tw

• MediaTek平台合作: synnex_6N@synnex.com.tw

• Rockchip平台合作: synnex_6N@synnex.com.tw

讓我們攜手開創地端AI的智慧新紀元,將創新轉化為競爭力,為您的產品注入真正的智能價值!